–===–

Ce billet invité a été rédigé par @xhark du très bon Blogmotion.

Je vous invite à consulter son blog qui fourmille d’information sur les systèmes et réseaux informatique.

–===–

Si comme moi vous aviez suivi le tutoriel d’installation de Centreon, vous devriez être en possession de Centreon 2.3.8. Ce guide a également été testé avec la version 2.3.9.

La version 2.4.0 de Centreon apporte de nombreux changements. Merethis, société éditrice de Centreon, a voulu se passer NDOutil à cause de sa lourdeur et de son manque d’efficacité sur des parcs d’une grande taille. On découvre alors un nouveau module broker maison « Centreon-broker », plus efficace et modulaire.

Dans mon cas j’ai souhaité préserver NDOutil dans un premier temps et faire une migration classique. Si vous souhaitez plus d’information sur Centreon-Broker vous trouverez des informations sur la documentation et je vous conseille ce guide. Si vous installez Centreon from scratch, ce guide (ou la doc officielle).

Mise à jour de votre système

Si vous utilisez une distribution Debian Like comme Ubuntu, vérifiez que vos paquets sont à jour :

# apt-get update && apt-get upgrade

Passons à la suite.

Mise à jour de Centreon

Avant tout, faites un snapshot si vous utilisez VMWare ou une copie de votre système (image) pour revenir en arrière en cas de pépin. Puis faire une sauvegarde du fichier sudoers :

# cp /etc/sudoers /root/etc-sudoers.bak

Si vous utilisez un serveur proxy pour accéder à internet, c’est le moment de le définir pour PEAR qui risque d’aller chercher des modules absents (c’était mon cas avec Archive_7zip) :

# pear config-set http_proxy "http://proxy:8080" config-set succeeded

Nous allons commencer par récupérer la dernière version de Centreon sur le site officiel. Pensez à remplacer le lien de téléchargement de Centreon (http://download.centreon.com/index.php?id=4264) ainsi que la version (centreon-2.4.0 au moment de la rédaction de ce billet) par la dernière version disponible.

Toutes les commandes sont effectuées avec le compte root (« su -« ) sur une distribution Ubuntu 12.04.2 LTS 32 bits.

cd /tmp/ wget http://download.centreon.com/centreon/centreon-2.4.0.tar.gz cd centreon-2.4.0 ./install.sh -u /etc/centreon

La trace complète est disponible ici, voyons les étapes importantes :

Do you want to use the last Centreon install parameters ?

[y/n], default to [y]:

> y

Using: /etc/centreon/instCentCore.conf

/etc/centreon/instCentPlugins.conf

/etc/centreon/instCentStorage.conf

/etc/centreon/instCentWeb.conf

Do you want to install : Centreon Web Front

[y/n], default to [n]:

> y

Do you want to install : Centreon CentCore

[y/n], default to [n]:

> y

Do you want to install : Centreon Nagios Plugins

[y/n], default to [n]:

> y

Do you want to install : Centreon Snmp Traps process

[y/n], default to [n]:

> y

Where is your Centreon binaries directory

default to [/usr/local/centreon/bin]

>

Where is your Centreon data informations directory

default to [/usr/local/centreon/data]

>

Do you want me to create this directory ? [/usr/local/centreon/data]

[y/n], default to [n]:

> y

What is the Centreon group ? [centreon]

default to [centreon]

>

Do you want me to create this group ? [centreon]

[y/n], default to [n]:

> y

What is the Centreon user ? [centreon]

default to [centreon]

>

Do you want me to create this user ? [centreon]

[y/n], default to [n]:

> y

What is the Broker user ? (optional)

>

What is the Monitoring engine log directory ?

> /usr/local/nagios/var

Where is your monitoring plugins (libexec) directory ?

default to [/usr/lib/nagios/plugins]

> /usr/local/nagios/libexec/

------------------------------------------------------------------------

Configure Sudo

------------------------------------------------------------------------

What is the Monitoring engine init.d script ?

> /etc/init.d/nagios

Where is the configuration directory for broker module ?

> /usr/local/nagios/etc ou /etc/nagios3

Where is the init script for broker module daemon ?

> /etc/init.d/ndo2db

Your sudo has been configured previously

Do you want me to reconfigure your sudo ? (WARNING)

[y/n], default to [n]:

> y

Do you want to reload your Apache ?

[y/n], default to [n]:

> y

Do you want me to install CentCore init script ?

[y/n], default to [n]:

> y

Do you want me to install CentStorage run level ?

[y/n], default to [n]:

> y

------------------------------------------------------------------------

Start CentCore Installation

------------------------------------------------------------------------

Do you want me to install CentCore init script ?

[y/n], default to [n]:

> y

Do you want me to install CentCore run level ?

[y/n], default to [n]:

> y

On peut maintenant ce rendre à l’URL suivante pour finaliser la mise à jour par l’interface Web:

http://<adresseIPserveur>/centreon/

REMARQUE: ne pas oublier le / à la fin…

Vérification du fonctionnement

Si vous le pouvez, redémarrez votre serveur pour être sûr que les services démarrent correctement.

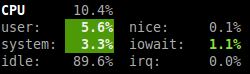

Pour vérifier que Centreon fonctionne correctement, exportez la configuration vers Nagios : Configuration > Monitoring Engines (anciennement appelé « nagios »). Cocher (en plus de celles déjà cochées) : Move Export Files et Restart Monitoring Engine.

Si comme moi vous obtenez le message d’erreur :

Preparing environment… OK

Generating files… OK

Moving files…NOK

Il s’agit d’un problème de droit, bien que l’erreur ne soit pas très parlante… après de nombreuses prises de tête pas mal de caféine, voici la solution :

# chown www-data:nagios /usr/local/nagios/ -R

A titre d’information, voici le contenu de mon fichier /etc/group :

nagios:x:1001:nagios,www-data,centreon centreon:x:999:www-data,nagios www-data:x:33:nagios

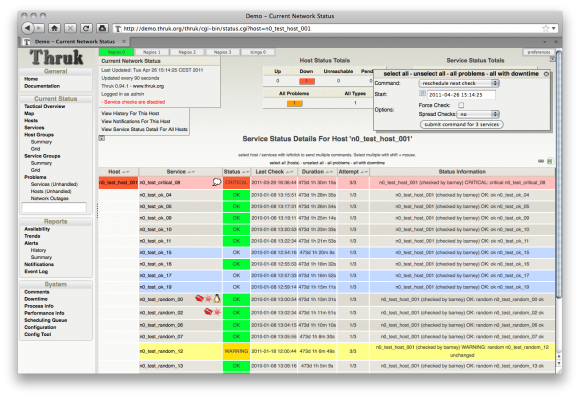

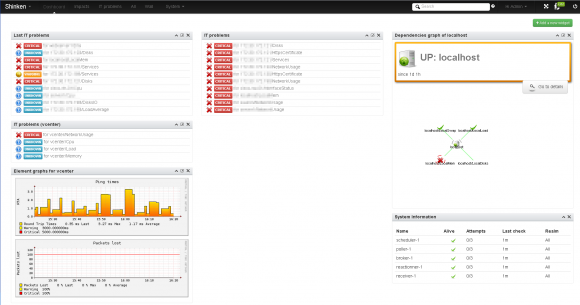

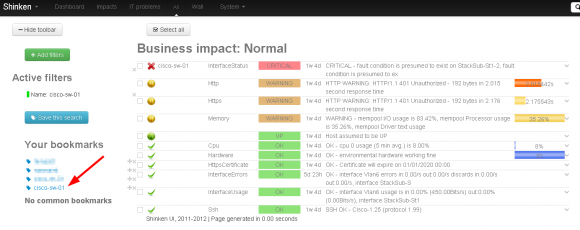

Vous verrez aussi que la page d’accueil de Centreon a pas mal évolué, avec des widgets mais c’est loin d’être intuitif car il faut tout configurer en dur. Pour l’instant, on s’en passera.

Si vous avez besoin d’aide je vous conseiller de lire ce billet sur l’utilisation de Centreon.

Enfin, je vous conseille d’installer Centreon Entreprise Server (CES) sur un serveur de test, il permet de tester toutes les configurations possibles (avec ou sans broker, NDO, poller standard, central, etc.). Le produit est libre en version Standard et il est basé sur CentOs 5.9 x64, des services supplémentaires payants sont disponibles pour les autres versions.

Je viens de mettre à jour mon dépôt GitHub des scripts de post installation d’Ubuntu pour prendre en compte le version 12.10 (Quantal). Pour rappel, ces scripts sont un moyen simple et modulaire de faire automatiquement un ensemble d’actions après l’installation standard du système d’exploitation.

Je viens de mettre à jour mon dépôt GitHub des scripts de post installation d’Ubuntu pour prendre en compte le version 12.10 (Quantal). Pour rappel, ces scripts sont un moyen simple et modulaire de faire automatiquement un ensemble d’actions après l’installation standard du système d’exploitation.